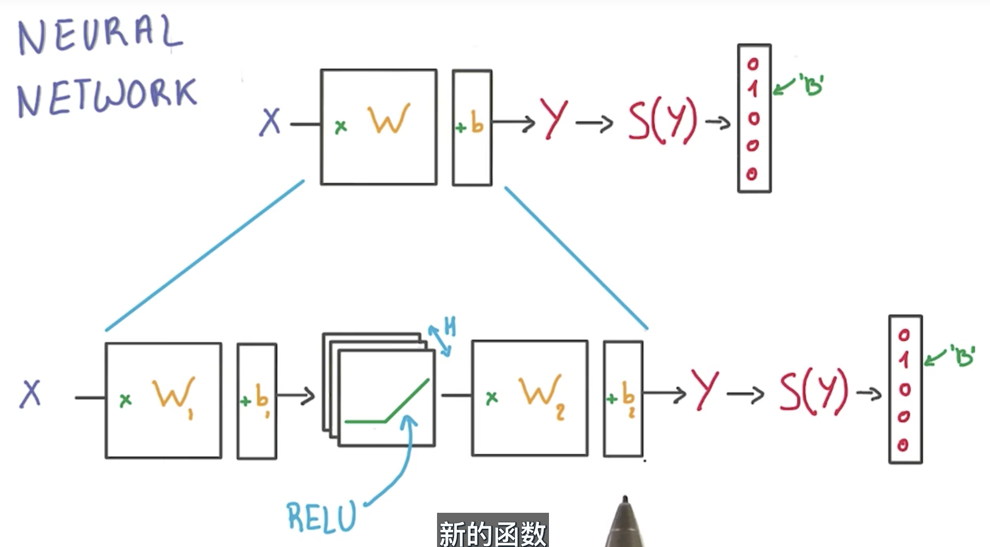

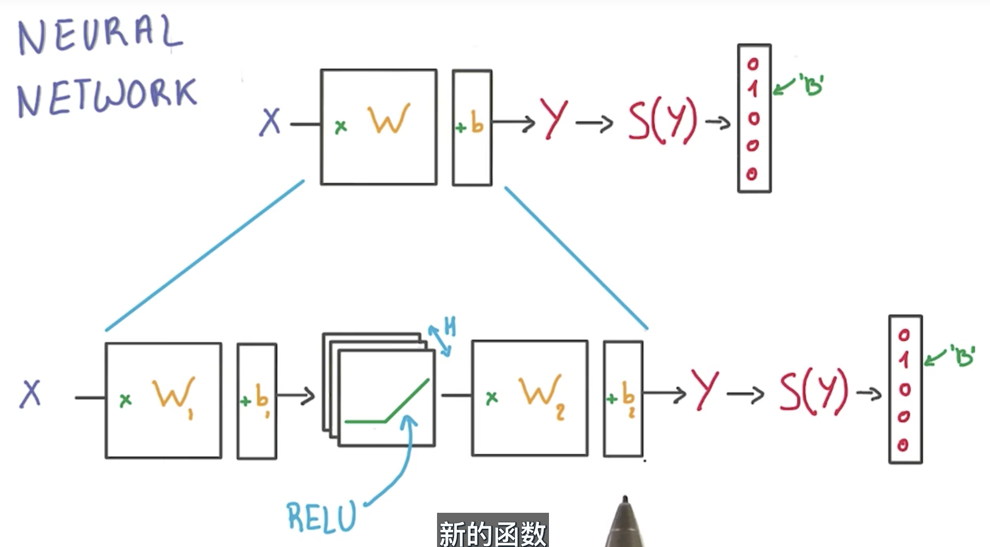

多层神经网络

一个常用的非线性函数叫 ReLU(rectified linear unit))。ReLU 函数对所有负的输入,返回 0;所有 x>0 的输入,返回 x。

两层神经网络

- 第一层由一组 X 的权重和偏差组成并通过 ReLU 函数激活。 这一层的输出会提供给下一层,但是在神经网络的外部不可见,因此被称为隐藏层。

- 第二层由隐藏层的权重和偏差组成,隐藏层的输入即为第一层的输出,然后由 softmax 函数来生成概率。

一个常用的非线性函数叫 ReLU(rectified linear unit))。ReLU 函数对所有负的输入,返回 0;所有 x>0 的输入,返回 x。

微信打赏

支付宝打赏